5 月 30 日消息,近日 Meta 团队开发了一款名为 Megabyte 的 AI 模型以抗衡 Transformer,据称 Megabyte 解决了 Transformer 模型所面临的问题,而且在速度上提升了 40%。

▲ 图源 Arxiv

目前 Transformer 在自然语言处理等领域非常流行,但由于其序列数据的处理方式是逐步进行的,无法并行化处理,因此训练速度较慢; 难以处理长序列,因为其在反向传播过程中,梯度很容易消失或爆炸;此外,由于需要在每一步保存历史信息,内存消耗较大。

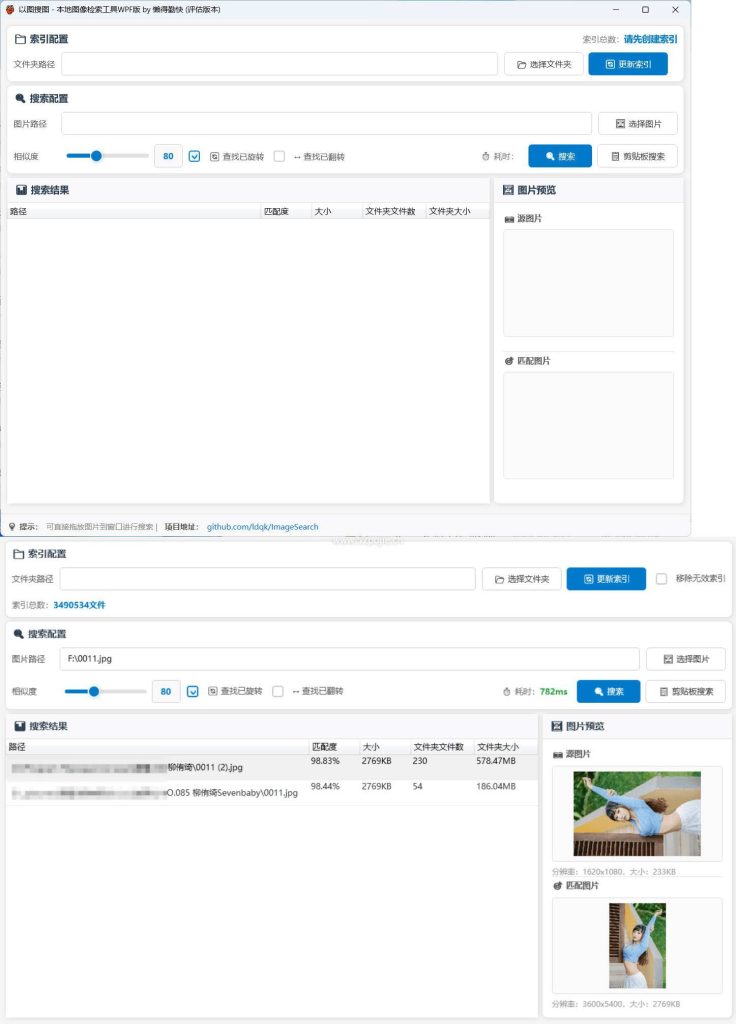

而 Megabyte 模型将输入和输出序列划分为 patch,而不是单个的 token。这种架构使得对大多数任务而言字节级另外预测相对于容易,例如按照前几个字符预测完成的单词等。这意味着在大型网络中可以精简字符以提升效率,而且内部预测可以使用更小的模型进行。Megabyte 模型的这种方法解决了当今 AI 模型所面临的训练速度、可靠性及硬件占用比挑战。

▲ 图源 Arxiv

此外,在计算效率方面,比拟于等大的 Transformer 和 Linear Transformer,Megabyte 模型在固定模型大小和序列长度范围内使用更少的 token。因此相对于于 Transformer,Megabyte 模型可以在相同的计算成本下训练内容更丰富、体积更大、性能更好的模型。

目前 Meta 团队放出了 Megabyte 模型的论文。

本网站名称:创码者资源网

本站永久网址: http://www.cmzym.top/

本站资源大多存储在云盘,如发现链接失效,请联系我们我们会第一时间更新。

本站为非盈利网站,一切付费内容(包括但不限于会员充值,资源付费),均为用户自愿赞助,且所有资金均用于网站维护

本站资源均收录于互联网,所以不能保证每个细节都符合你的要求,也可能存在未知的BUG与瑕疵,因虚拟资源可复制特性,所以不接受任何理由的退款兑现,请阅 读本站声明和相关条款后再进行支付下载

本站一切资源不代表本站立场,并不代表本站赞同其观点和对其真实性负责。

本网站的文章部分内容可能来源于网络,仅供大家学习与参考,如有侵权,请联系站长 :1326632303@qq.com 进行删除处理。

本本站采用知识共享署名-非商业性使用-相同方式共享4.0国际许可协议进行许可

暂无评论内容