什么是 Robots.txt 文件?

robots.txt 文件是一组指令,告诉搜索引擎要抓取哪些页面以及要制止哪些页面,指导抓取工具拜访但纷歧定会将页面排除在百度索引之外。此文件位于网站的根目录中,为搜索引擎爬虫提供网站范围内的指令,说明它们应该和不该该爬取网站的哪些区域

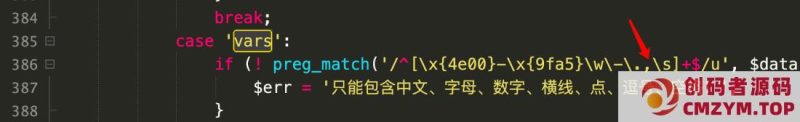

robots.txt 文件如下所示:

为什么Robots.txt对SEO很重要?

robots.txt 文件对于 SEO 很重要,因为它有助于管理网络爬虫活动,以防止它们使您的网站超载并抓取不供大众拜访的页面。

以下是使用 robots.txt 文件的一些原因:

1.优化抓取预算

使用 robots.txt 阻止没必要要的页面可让百度的网络爬虫将更多的抓取预算(百度在必然时间范围内将抓取您网站上的多少页面)花在重要的页面上。

抓取预算会按照您网站的大小、安康状况和反向链接的数量而有所差别。

如果您的网站的页面数量超出其抓取预算,重要页面可能无法被编入索引。

未编入索引的页面不会排名,这意味着您浪费了时间创建用户在搜索结果中永远看不到的页面。

2. 屏蔽重复和非公开页面

并非所有页面都适合包括在搜索引擎结果页面 (SERP) 中,而 robots.txt 文件可让您阻止爬虫程序拜访那些非公开页面。

考虑暂存网站、内部搜索结果页面、重复页面或登录页面。一些内容管理系统会自动处理这些内部页面。

例如,WordPress 禁止所有爬虫拜访登录页面“/wp-admin/”。

3.隐藏资源

如果您希望将 PDF、视频和图像等资源窃密,或者让百度专注于更重要的内容,Robots.txt 可让您将其排除在抓取范围之外。

Robots.txt 文件如何工作?

robots.txt 文件告诉搜索引擎机器人要抓取哪些 URL 以及(更重要的是)要制止抓取哪些 URL。

当搜索引擎机器人抓取网页时,它们会发现并跟踪链接。这个过程会引导它们从一个网站到另外一个网站的差别页面。

如果机器人找到 robots.txt 文件,它会在抓取任何页面之前读取该文件。

如何查找 robots.txt 文件

您的 robots.txt 文件托管在您的服务器上,就像您网站上的其他文件一样。

您可以在浏览器中输入网站主页 URL 并在末尾添加“/robots.txt”来查看任何网站的 robots.txt 文件。

例如:“https://www.xmy7.com/robots.txt”。

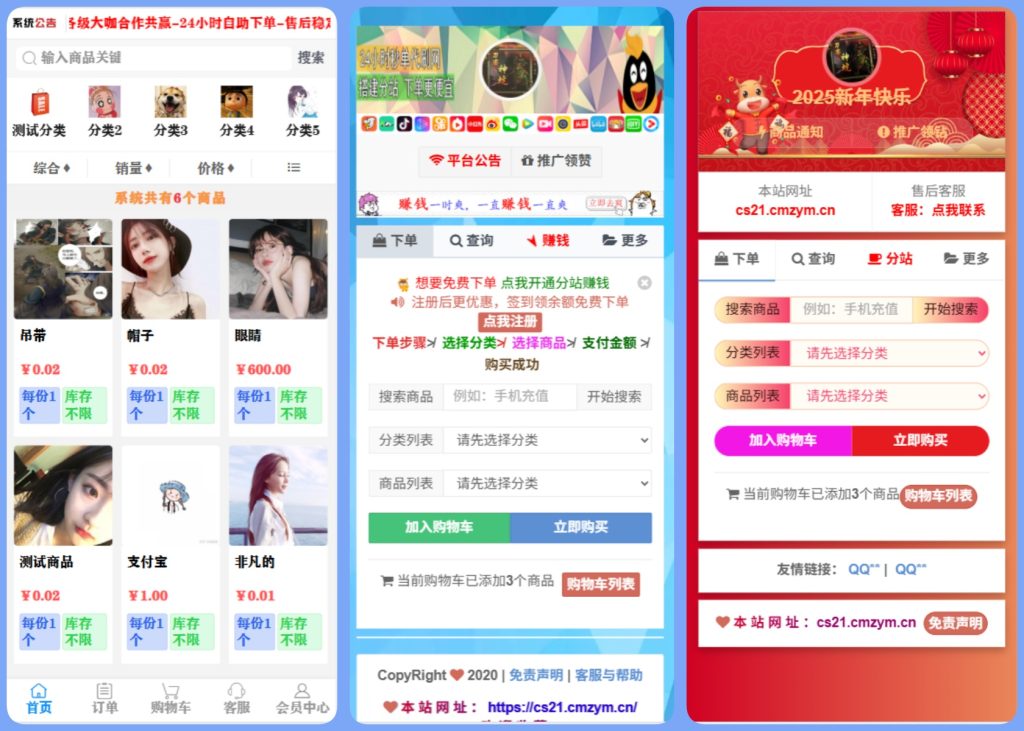

本网站名称:创码者资源网

本站永久网址: http://www.cmzym.top/

本站资源大多存储在云盘,如发现链接失效,请联系我们我们会第一时间更新。

本站为非盈利网站,一切付费内容(包括但不限于会员充值,资源付费),均为用户自愿赞助,且所有资金均用于网站维护

本站资源均收录于互联网,所以不能保证每个细节都符合你的要求,也可能存在未知的BUG与瑕疵,因虚拟资源可复制特性,所以不接受任何理由的退款兑现,请阅 读本站声明和相关条款后再进行支付下载

本站一切资源不代表本站立场,并不代表本站赞同其观点和对其真实性负责。

本网站的文章部分内容可能来源于网络,仅供大家学习与参考,如有侵权,请联系站长 :1326632303@qq.com 进行删除处理。

本本站采用知识共享署名-非商业性使用-相同方式共享4.0国际许可协议进行许可

暂无评论内容