禁止直接访问robots.txt文件

很久没去360站长平台,一直听说他把robots当漏洞来处理,其实很不地道,也就为了推广他家主机卫士吧,实际上这个算不上漏洞,充其量是因此泄露而已!

以下代码是禁止直接访问,但匹配并排除搜索引擎蜘蛛

nginx站点配置文件中加入以下节点:

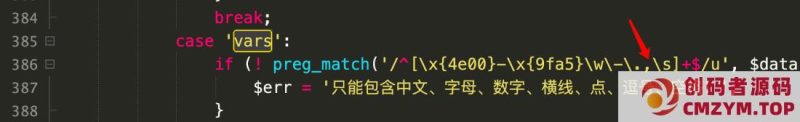

location = /robots.txt {

if ($http_user_agent !~* \”spider|bot|yahoo|sogou\”) {

return 404;

}

}

nginx

然后重载nginx配置

/usr/local/shuyangwang/nginx/sbin/nginx -s reload (此配置文件路径以你安装为准)

本网站名称:创码者资源网

本站永久网址: http://www.cmzym.top/

本站资源大多存储在云盘,如发现链接失效,请联系我们我们会第一时间更新。

本站为非盈利网站,一切付费内容(包括但不限于会员充值,资源付费),均为用户自愿赞助,且所有资金均用于网站维护

本站资源均收录于互联网,所以不能保证每个细节都符合你的要求,也可能存在未知的BUG与瑕疵,因虚拟资源可复制特性,所以不接受任何理由的退款兑现,请阅 读本站声明和相关条款后再进行支付下载

本站一切资源不代表本站立场,并不代表本站赞同其观点和对其真实性负责。

本网站的文章部分内容可能来源于网络,仅供大家学习与参考,如有侵权,请联系站长 :1326632303@qq.com 进行删除处理。

本本站采用知识共享署名-非商业性使用-相同方式共享4.0国际许可协议进行许可

暂无评论内容